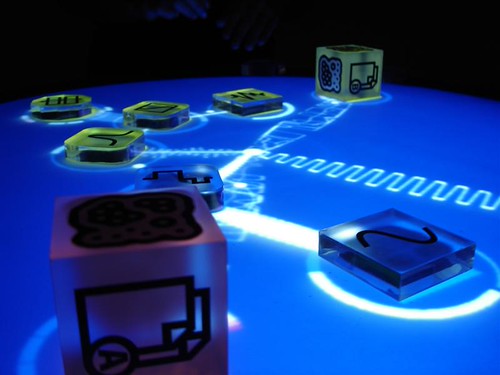

La notizia non ha trovato grande eco presso i media italiani ma merita di essere qui ripresa: Deutsche Borse ha annunciato l’avvio, indicativamente per l’inizio del 2014, delle contrattazioni elettroniche su una particolare tipologia di “merce”: lo storage e le risorse di calcolo (CPU, RAM, etc.). Se l’intenzione è quella di ampliare in futuro l’offerta, per il momento l’obiettivo è di far incontrare tutti coloro che da una parte hanno bisogno di ulteriori spazi di memorizzazione e di computing capacity e coloro che, dall’altra, ne hanno in surplus.

Si tratta di una notizia che lascia solo per certi versi sorpresi: era infatti prevedibile che il medesimo processo di commoditisation che ha investito il settore dei personal computer prima o poi avrebbe riguardato anche quello “immateriale” dei servizi erogati in modalità cloud.

Ciò nonostante lascia perplessi la prospettiva di vedere il prezzo dello storage, sul quale qui per ovvi motivi mi concentro, fluttuare in base alle bizze dei mercati ed essere acquistato da broker alla stregua di un barile di petrolio o di una tonnellata di granaglie! Bisogna infatti chiedersi se, similmente a quanto accaduto con altri mercati, anche attorno a questo verrà costruito quel castello di prodotti finanziari che, portati all’estremo, tanti danni ha provocato. Considerando infatti che secondo molti analisti l’esistenza di un simile mercato va incontro all’esigenza, percepita da molti attori, di possedere spazi di memorizzazione in diverse giurisdizioni (agevolando in tal modo la compliance alle norme ed agli standard in vigore nei diversi Stati) non ci sarebbe da stupirsi se si tutelasse l’investimento (poniamo che uno debba comprare spazio di storage in Egitto, giusto per fare un esempio di estrema attualità) con quegli strumenti finanziari (vedi gli swap) tristemente famosi.

Ma al di là delle considerazioni finanziarie quello che preoccupa “archivisticamente” è la “banalizzazione dello storage” sottesa al processo di commoditisation: nonostante le rassicurazioni fornite da Deutsche Borse in ordine all’elevato livello qualitativo delle risorse ammesse alle contrattazioni e la presenza di operatori dalle indubbie capacità (a riguardo vengono citati non solo operatori commerciali come T-Systems ma anche soggetti appartenenti al mondo accademico come il Leibniz Rechen-Zentrum il quale, per intenderci, fornisce i servizi informatici per le varie università di Monaco di Baviera nonché per l’Accademia Bavarese delle Scienze), confesso che nutro più di una perplessità sulla qualità “archivistica” del servizio che verrà acquistato.

Mi sembra infatti lontano anni luce il mondo degli archivi, istituti impiantati (e uso questo termine proprio per sottolineare la solidità che li dovrebbe contraddistinguere nel tempo!) per durare secoli, con l’aleatorietà di uno scambio di borsa portato a termine in maniera telematica: detta in altri termini mi pare che la comprensibile fretta di avere ulteriore spazio di storage nella quale può venirsi a trovare un qualsivoglia soggetto produttore (perché questo è in ultima analisi il compratore!) mal si concili con i tempi, inevitabilmente più lunghi, necessari per realizzare un consistente sistema archivistico. Ritorniamo dunque al problema di fondo, ripetutamente evidenziato in questo blog, che lo storage, così com’è concepito da molti provider, ha spesso gran poco da condividere con l’archiviazione.

Naturalmente i miei possono essere timori infondati ed anzi l’auspicio è proprio che, dopo la seicentesca bolla dei tulipani, non ci si ritrovi a fronteggiare, nel prossimo futuro, ad una non meno bizzarra bolla dello storage!

Posts Tagged ‘storage’

6 Lug

Al mercato dello storage

15 Mar

Capacità di storage come asset centrale della biblioteca del futuro?

In un mio post di qualche tempo fa mi soffermavo sulla crescente importanza, per i moderni archivi digitali, che va assumendo l’infrastruttura tecnologica.

Ovviamente da questo trend non sono immuni nemmeno le biblioteche e la riprova la si ha leggendo la notizia, diffusa pochi giorni fa, della partnership instaurata tra EMC, colosso statunitense con quasi quarant’anni di esperienza alle spalle nei sistemi di storage ed archiviazione, e la Biblioteca Apostolica Vaticana: in estrema sintesi EMC, all’interno di un più vasto programma che unisce saggiamente filantropia a marketing, si impegna a fornire le risorse di storage necessarie ad immagazzinare l’intero patrimonio di libri manoscritti, incunaboli e cinquecentine che ci si appresta, in un arco di tempo stimato in tre anni, a digitalizzare.

Se ad impressionare è l’enorme spazio di memorizzazione messo a disposizione, ovvero 2,8 petabyte (equivalenti a 2.936.012,800 gigabyte; per rendere l’idea tale cifra la si raggiunge unendo 587.202 computer con disco rigido da 500 GB), non meno importanti sono le riflessioni che si possono ricavare da questa vicenda.

Innanzitutto appare evidente come una simile infrastruttura abbia dei costi particolarmente elevati (peccato che nulla venga detto a proposito e che non sia nemmeno possibile fare ipotesi, non essendo noto il tipo di memoria adottato) ed anzi probabilmente fuori dalla portata della maggior parte delle biblioteche al mondo.

Ma quel che più conta è il ruolo strategico assunto dall’infrastruttura di storage: essa infatti funge da ponte imprescindibile tra passato, cioè i libri “analogici” posseduti, e futuro, ovvero la loro copia digitalizzata, la quale consentirà a) di “risparmiare” ai primi tutti quegli stress meccanici derivanti dall’uso nonché l’esposizione a fattori ambientali quali luce, (sbalzi di) umidità e temperatura, etc. b) di far godere, nel presente, questi capolavori ad una platea di pubblico potenzialmente molto più vasta rispetto a quella degli studiosi che solitamente ha la fortuna di consultarli.

Sarebbe stato bello, per concludere, sapere qualche dettaglio tecnico-operativo in più, ad esempio se chi si occuperà della gestione del sistema di storage (verosimilmente tecnici EMC) sarà sotto la sovrintendenza del Prefetto della Biblioteca Vaticana, monsignor Pasini o, in alternativa, quale tipo di controlli verranno messi in atto per assicurarsi che il sistema risponda a tutti i requisiti in termini di sicurezza ed operatività.

Non meno interessante sarebbe sapere dove effettivamente è localizzato il data center (e se esiste un sito secondario) così come se si fa ricorso al modello del cloud computing…

Tante domande che non fanno che rafforzare la mia convinzione che le capacità di storage siano un asset strategico per le biblioteche.

30 Gen

Fenomeno cyberlocker, alcune considerazioni

Il recente caso di cronaca giudiziaria che ha riguardato la “galassia Megaupload” ha portato alla ribalta il fenomeno, forse a molti sconosciuto ma in realtà assai diffuso, del cyberlocking. Dal momento che la vicenda nel suo complesso induce ad alcune riflessioni che a mio vedere sono, per così dire, di “pertinenza archivistica”, vediamo un po’ in cosa consiste questo “cyberlocking” e perché Megaupload è stato chiuso.

In estrema sintesi si tratta di servizi (Megaupload non è che uno, e forse nemmeno il più famoso; altri sono RapidShare, HotFile, FilesTube, DepositFile) che mettono a disposizione dell’utente uno spazio di archiviazione in genere di considerevoli dimensioni al quale si può accedere, in linea con il paradigma proprio del cloud computing, a partire da qualsiasi dispositivo. Fin qui si potrebbe pensare che i cyberlocker siano del tutto assimilabili a quei siti di online storage (come Dropbox, aDrive, etc.) dei quali ho più volte parlato; in realtà essi si differenziano perché la dimensione di sharing prevale nettamente su quella di archiviazione: infatti ogni file uploadato può diventare accessibile tecnicamente a chiunque, basta rendere pubblico il relativo URL, ed i gestori hanno tutto l’interesse ad aumentare il traffico chiudendo un occhio (e pure l’altro!) qualora in presenza di quel materiale “piratato” che ovviamente risulta maggiormente appetibile. Non a caso l’FBI, tra le motivazioni addotte per giustificare la chiusura di Megaupload, l’arresto dei suoi amministratori ed il sequestro dei loro beni, ha espressamente chiarito come il “sistema” non fosse congeniato per l’archiviazione personale e/o di medio – lungo periodo al punto che i file poco “attivi” (= quelli che non venivano scaricati un sufficiente numero di volte) venivano sistematicamente cancellati. Al contrario, sempre stando all’FBI, gli amministratori del sito non erano così solerti nel cancellare quei file, guarda caso quelli maggiormente scaricati, lesivi di diritti intellettuali e di proprietà (film, ebook, software, etc.). E per quella quota minoritaria di utenti (alcuni anche premium, ovvero a pagamento) che usavano legalmente Megaupload oltre al danno di trovarsi da un giorno all’altro impossibilitati di accedere ai propri dati ora si profila anche la beffa: essendo tutti i beni di Megaupload sequestrati, la società non è in grado di pagare quelle aziende subappaltatrici fornitrici dell’indispensabile spazio di hosting, come Cogent Communications e Carpathia Hosting. Morale della favola: se entro giovedì non vedranno saldate le “bollette”, queste ultime procederanno con l’eliminazione definitiva dei dati detenuti per conto di Megaupload (in questo senso mi permetto di dire che l’operazione dell’FBI avrebbe potuto essere più selettiva, colpendo coloro che oggettivamente hanno infranto la legge e tutelando invece gli utilizzatori onesti).

Alla luce di tutto ciò la vicenda assume un valore emblematico di quel che è attualmente l’ “archiviazione” sulla nuvola: una scelta talvolta obbligata (si pensi a tutti coloro che lavorano a distanza e su moli di dati cospicue) ma ancora rischiosa, non tanto per la scarsa affidabilità tecnologica (non che l’evenienza di un crash dei server sia scongiurata, si badi) ma soprattutto per la pratica diffusa del subappalto a terzi dei “concreti” servizi di hosting, il che finisce per trasformare il sistema in un complesso “gioco” di scatole cinesi, in cui più che l’opportuna localizzazione geografica delle server farm conta la legislazione più favorevole ed il regime fiscale vigente (da quel che ho potuto ricostruire – in Rete ho letto differenti versioni – Megaupload era una società gestita da cittadini olandesi e tedeschi con sede legale in Nuova Zelanda e server ad Hong Kong).

Per concludere, una storia che mette in luce una volta di più come gli archivi di persona siano tra quelli più a rischio nell’era digitale e come si renda necessario “instillare” nei singoli cittadini / utenti una particolare sensibilità per la “sopravvivenza” dei propri dati e documenti, cosa che a mio avviso (nell’attesa che gli archivi “pubblici” – non oso dire di Stato – fiutino l’affare e si riposizionino sul settore) al momento può avvenire solamente attraverso la moltiplicazione delle copie, in locale e sulla nuvola. In quest’ultimo caso ovviamente discriminando tra provider buoni e cattivi!

15 Ott

Archivi in the cloud

PREMESSA

Più volte in questo blog ho fatto riferimento al cloud computing ed alle sue ricadute archivistiche (e biblioteconomiche). Dal momento che non mi sembra ci sia molta chiarezza a riguardo, provo a farne un po’ io, in particolare spiegando cos’è questo fantomatico paradigma tecnologico e cosa si intende dire quando si afferma che “un archivio va sulla nuvola”.

DEFINIZIONE

Partiamo dall’inizio: la definizione di cloud computing è assai eterogenea e ne esistono più declinazioni, personalmente trovo che quella fornita da Rinaldo Marcandalli sia una delle più esaurienti, ovvero: “un insieme (o combinazione) di servizi, software e infrastruttura It offerto da un service provider accessibile via Internet da un qualsiasi dispositivo. Tutto si traduce in offerta di servizio, che in funzione dell’entità erogante può essere categorizzata in quattro generi: basata sul Web (il genere Rich Internet application da Flickr a Microsoft Office Live); Software as a Service o Saas (applicazioni accessibili Internet e customizzabili come Gmail e Salesforce.com); Platform as a Service o Paas (esempi classici le piattaforme Force.com e Google App Engine); Infrastructure as a service o Iaas (servizi infrastrutturali di capacità di elaborazione virtualizzata tipo Amazon Elastic compute cloud o Ec2, o di hosting di server virtualizzati o di utilità storage; importante osservare che Iaas può venir erogata da un data center pubblico o privato)”.

Si noterà che molti degli esempi riportati da Marcandalli non rappresentano novità assolute, al contrario riguardano servizi noti al grande pubblico; in effetti il tratto distintivo di un servizio in cloud computing non dipende tanto dal suo livello di innovatività ma piuttosto dalla modalità di erogazione (in questo senso i requisiti di scalabilità e personalizzazione sono essenziali).

GLI ARCHIVI SULLA NUVOLA

Come si sarà evinto dalla lettura della definizione appena data, all’interno della tipologia definita come IaaS vi è la precisa funzione di “utilità storage“, che è quella qui di nostro principale interesse e che andrò ora ad analizzare (da notare bene che per il soggetto erogante tale servizio si colloca a livello infrastrutturale mentre per il client si tratta di accedere ad un servizio basato online, ovvero ricadente all’interno di una delle due prime categorie a seconda del grado di customizzazione). In soldoni si tratta della possibilità, per individui ed organizzazioni pubbliche e private, di “archiviare” i propri dati e documenti all’interno di server remoti sui quali in genere NON SI HA alcun controllo. Se fino a ieri dunque la destinazione di questi dati erano le varie unità di archiviazione di massa di tipo generalmente magneto-ottico (dagli hard disk esterni ai juke box di CD/DVD, passando per tape library e via discorrendo) di proprietà, oggi essi finiscono in server residenti in luoghi talvolta non geograficamente determinati, aspetto che rende il ricorso al termine “nuvola” del tutto calzante ma che pone nel contempo numerosi problemi pur a fronte di alcuni innegabili vantaggi.

I VANTAGGI

Abbracciare il modello del cloud computing garantisce alcuni innegabili vantaggi per coloro (privati ed organizzazioni) che effettuano questa scelta: a) essi hanno il vantaggio economico e “gestionale” di non dover più preoccuparsi di comprare e, per l’appunto, gestire, lo spazio di memoria necessario a contenere i propri dati e documenti (si tratti del disco rigido esterno da poche decine di euro o del server da qualche migliaio, la sostanza non cambia) b) in linea di principio i propri dati e documenti vengono messi al riparo dai rischi di perdita, corruzione, cancellazione, etc. (poi anche le server farm possono andare a fuoco, ma su questo meglio sorvolare…) c) caricare i propri dati e documenti sulla nuvola è in linea con l’evoluzione che sta interessando il modo di organizzare l’attività lavorativa nonché la gestione delle risorse umane: lavoro in condivisione e senza l’obbligo di trovarsi fisicamente in uno specifico ufficio o sede di lavoro, in quanto vi si può accedere attraverso molteplici dispositivi (tablet, notebook, netbook, smartphone, etc.). Il risultato ultimo di tutto ciò è non solo una ridefinizione dei carichi individuali e dei flussi di lavoro (inclusi quelli documentari), ma pure un aumento nella circolazione di idee, della conoscenza collettiva e (si spera) della produttività.

I PROBLEMI

Nella definizione data da Marcandalli si parla di “utilità di storage”, anche se è invalso l’uso del termine di “archivi sulle nuvole” come suo sinonimo, benché qualunque archivista abbia perfettamente presente come quest’uguaglianza sia ben lungi dal corrispondere al vero! Come bisogna dunque considerare questi servizi? Come meri “depositi” oppure come archivi? Una veloce analisi di un campione di essi basta ed avanza per evidenziare carenze tanto dal punto di vista teorico quanto da quello pratico, tali da far propendere indubbiamente per la prima opzione.

Dal punto di vista teorico semplicemente non è possibile parlare di archivio, dal momento che il client sceglie (con modalità differenti da servizio a servizio) quali dati e documenti caricare sulla nuvola sicché si viene a creare una completa discrasia tra l’archivio presente in locale e quello in remoto cosa che a sua volta fa venir meno la necessaria organicità oltre che il fondamentale concetto di vincolo archivistico (e qui non mi sto riferendo al tradizionale vincolo puro, ma al concetto “nuovo” di vincolo impuro sviluppato in ambito di archivio informatico da autori come Antonio Romiti!). A rafforzare un tale drastico giudizio contribuisce poi la mancanza de facto di un contesto così come l’assenza di una profondità temporale (di norma i documenti sono datati solamente a partire dal momento dell’upload, con un evidente effetto distorsivo).

Non meglio vanno le cose se si esaminano tali servizi per quanto riguarda il profilo tecnico e legislativo; infatti, usando come criteri di valutazione quelli suggeriti da Chenxi Wang in un interessante report redatto per Forrester (peraltro sovrapponibile in molti punti alle MOIMS-RAC stilate dal Consultative Committee for Space Data Systems), i servizi in analisi risultano quanto meno carenti circa i seguenti aspetti: 1) integrità dei dati uploadati non garantita, con risarcimenti nulli o irrisori in caso di loro perdita 2) loro residenza ignota (spesso le aziende si giustificano asserendo che il non rivelare l’ubicazione dei data center fa parte della stessa politica di sicurezza e prevenzione) 3) salvo rari casi, non viene esplicitato in alcun modo il tipo di architettura adottata (ad es. RAID3, 4, etc.) così come gran pochi cenni si fanno alle politiche in fatto di disaster prevention, business continuity e le relative misure adottate (e questo è paradossale, essendo proprio il desiderio di cautelarsi da simili evenienze a spingere molti CIO ad adottare il modello del cloud computing… in pratica a volte si abbandona il noto per l’ignoto!) 4) assenza di audit, con il risultato che talvolta è impossibile stabilire chi e quando “ci ha messo le mani” e su quali e quanti di questi dati e documenti 5) scarsi e/o generici riferimenti alle leggi di riferimento in tema di privacy, etc.

LE SOLUZIONI

Anche alla luce di molte di quelle problematiche individuate nel precedente paragrafo si sono cercati dei correttivi tali da far accettare il modello cloud anche ai responsabili delle strutture informatiche più restii, senza però che tali correttivi togliessero quegli elementi di indubbio vantaggio. A riguardo, essendo uno degli aspetti più critici (e criticati) quello della sicurezza (fisica e “intellettuale” dei dati e documenti caricati), molte organizzazioni stanno creando delle private cloud, ovvero delle infrastrutture tecnologiche che ricalcano i medesimi principi di una “normale” nuvola (definita per distinguerla dalla precedente public cloud) ma che sono usate esclusivamente dalle organizzazioni stesse che le realizzano. Così facendo si godono dei vantaggi elencati e si annullano per contro gli aspetti negativi; l’unico neo è che una simile opzione è praticabile solo da realtà grosse e dotate del necessario capitale finanziario, umano e tecnologico mentre quelle più piccole ed i singoli individui non potranno che affidarsi a quello che c’è sul mercato! A questi ultimi, dunque, non resta altro che cercare di contrattare con il fornitore servizi il più possibile vicini ai propri desiderata.

Un’altra strada percorsa è quella seguita da Amazon con il governo degli Stati Uniti, con la prima che ha “riservato” al secondo una cloud specifica ed ottemperante ai particolari e più restrittivi requisiti del “cliente” Federale.

Dal momento che non tutti hanno il peso contrattuale del governo statunitense, sono state poi trovate ulteriori soluzioni intermedie, com’è il caso delle cosìdette hybrid cloud, che come suggerisce il nome presentano elementi dell’una e dell’altra soluzione.

LE PROSPETTIVE

Dando credito alle previsioni delle principali società di analisi e ricerca del mercato, il futuro del cloud computing è roseo: secondo Gartner il suo giro d’affari complessivo nel 2010 si è attestato attorno ai 68 miliardi di dollari. Il peso complessivo dello storage all’interno di questo settore è preminente ed assicurerebbe quasi la metà degli introiti. E che “gli archivi sulla nuvola” siano un business che porta guadagni lo confermano gli stessi operatori. La statunitense Dropbox è quotata attorno ai 4 miliardi di dollari e persino in Italia Telecom, che ha lanciato “Nuvola Italiana”, lo ha definito un “business profittevole”! Se dunque sembra proprio che dovremo abituarci alla prospettiva che i nostri “archivi” finiscano sulla nuvola, possiamo almeno sperare che intervengano alcuni fattori correttivi di questi servizi. Ad esempio l’inserimento di metadati rappresenterebbe già un notevole passo in avanti, così come la partecipazione degli archivisti nella fase di progettazione delle private cloud che sicuramente le Pubbliche Amministrazioni vorranno realizzare sarebbe un altro aspetto sicuramente positivo. In generale, poi, vale la raccomandazione di leggere attentamente i “Termini & Condizioni” del servizio e cercare di valutare l’affidabilità della soluzione tecnologica proposta (l’assenza di specifiche tecniche sulle quali poter effettuare valutazioni è di suo un elemento negativo!), personalizzandoli ove possibile.

CONCLUSIONI

Da quanto scritto si capisce come negli “archivi sulla nuvola” vi sia la compresenza di aspetti positivi e negativi; nell’attesa che anche questi servizi maturino (e nella convinzione che ciò equivarrà ad un loro miglioramento) credo stia all’utilizzatore finale discriminare tra buoni e cattivi servizi. In altri termini il buon senso come principio guida è l’unico mezzo per non rimanere “scottati” da una parte e perdere il treno dell’innovazione tecnologica dall’altra perché, credo di non essere troppo enfatico sostenendo ciò, il futuro degli archivi passa anche dalla nuvola.

Per la versione su Storify con puntuali riferimenti a documenti e notizie alla base di questo post cliccate qui.

12 Set

Conservazione della memoria digitale & dintorni

Lo spunto di questo post mi è stato offerto dalla recente discussione, a dire il vero nemmeno tanto appassionata ed alla quale io stesso ho partecipato, che si è svolta sulla lista Archivi 23 sull’annoso ed intricato tema della conservazione della memoria digitale e sulle sue modalità di “implementazione” presenti e future.

L’input al dibattito è stata la richiesta di pareri su un “nuovo” tipo di disco ottico (chiamato M-Disk) prodotto da Millenniata e che, come suggerisce il nome, dovrebbe durare 1000 anni senza deteriorarsi in virtù dei materiali usati (nel sito non viene spiegato chiaramente come siano costruiti, si dice solo che l’uso di materiali inorganici ed altri metalloidi li rendono “non deperibili” come i “mortali” DVD). L’altro motivo che consenti(rebbe) ai dati / documenti memorizzati su tali DVD di rimanere leggibili in perpetuum è il fatto che l’incisione della superficie del disco avviene molto più a fondo, in quanto si fa ricorso ad un laser assai più potente rispetto ai consueti. Proprio per quest’ultimo motivo occorre usare un apposito “masterizzatore” prodotto da LG e che a seconda del modello (= del prezzo) può scrivere anche su CD, DVD “normali” e Blu-Ray.

Ora, sorvolando il fatto che tali decantate qualità siano più o meno vere (Millenniata porta a supporto test condotti presso il Naval Air Warfare Center di China Lake), nella Lista è stato fatto notare che: 1) la presenza di dischi ottici indistruttibili non risolve il problema dell’obsolescenza dell’hardware e del software 2) che la tendenza in fatto di archiviazione / storage, pur con tutti i noti problemi, va inesorabilmente nella direzione della cloud; quest’ultimo richiamo al cloud computing ha comportato una levata di scudi da parte di alcuni membri della Lista (significativamente si trattava di addetti nel settore informatico; tentativo di difesa di business consolidati o competente presa di posizione?) i quali in sostanza considerano il cloud una montatura o quanto meno uno specchietto delle allodole grazie al quale si spacciano per nuovi concetti vecchi, in ogni caso negando la possibilità che esso comporti concreti vantaggi. Per contro veniva salutato positivamente il “passo in avanti” compiuto con la comparsa dell’M-Disk in quanto, è stato sostenuto, almeno il problema dell’affidabilità / durabilità dei supporti di memorizzazione trovava una soluzione.

D’accordo, la speranza è l’ultima a morire, ma dovendo ragionare e soprattutto agire hic et nunc credo che l’idea di ricorrere a supporti di memorizzazione simili a quelli proposti da Millenniata non abbia molto senso e questo perché: 1) si è vincolati, in fase di scrittura, al prodotto di LG il quale, come tutti gli altri prodotti hardware, nel giro di 5 – 10 anni sarà, per l’appunto, obsoleto; bisognerà dunque sperare che LG (se esistente, cosa tutt’altro che garantita considerando i processi di merge & acquisition in atto) assicuri nel tempo la produzione dei nuovi “masterizzatori” 2) fatti quattro rapidi conti non è conveniente spendere per M-Disk che costano (al dettaglio) mediamente due dollari e mezzo in più l’uno a parità di capacità di memorizzazione (4,7 GB) se poi non potrò usarli per la predetta obsolescenza HW e SW! Che me ne faccio di dati / documenti se poi non li posso leggere / usare?! 3) Interpares ha ormai accettato il fatto che i documenti siano (relativamente) “cangianti” e che il loro “habitat” sia un sistema documentale; a mio parere che tale sistema documentale “lavori” in una server farm situata presso la sede principale dell’organizzazione (e presumibilmente altra sede decentrata) o che al contrario stia, sfruttando la nuvola, a migliaia di kilometri di distanza poco importa! Essenziale è che questa nuvola (private, common o hybrid che sia) risponda a requisiti di sicurezza (fisica e legale), tutela dei dati, integrità, affidabilità, etc. In altri termini non vedo una contraddizione tra i principali risultati teorici di Interpares (quale il concetto della permanenza all’interno del sistema, che a sua volta riprende l’istituto anglo-sassone dell’ininterrotta custodia) ed il passaggio alla nuvola, garantendo quest’ultima (se fatta bene) la medesima permanenza all’interno del sistema che può essere assicurata da una server farm tradizionale, con tutto ciò che ne consegue, vale a dire, per l’oggetto specifico di questo post, la progressiva scomparsa delle memorie di tipo ottico.

PS Sono conscio che le prassi operative di molte server house prevedono che i dati / documenti “correnti” vengano memorizzati su nastri magnetici dall’ottimo rapporto prezzo / Gb mentre quelli “storici” in tradizionali dischi ottici di norma “impilati” in juke-box o secondo altre più complesse architetture, ma nondimeno ritengo che questa soluzione, in linea con la tendenza generale verso la “dematerializzazione”, svolgerà un ruolo progressivamente residuale.